모델스코프(ModelScope)는 설명 텍스트를 입력하면 텍스트 설명과 일치하는 동영상을 반환하는 다단계 텍스트-동영상 생성 확산 모델을 기반으로 합니다. 현재는 영어 입력만 지원되는 텍스트-비디오 생성 확산 모델 ModelScope는 텍스트를 입력하면 대략 2초에서 4초까지의 영상을 만들어주며 현재 Hugging Face에서 무료로 사용이 가능합니다. 글자를 동영상으로 바꿔주는 AI를 지금 무료로 이용해보세요. (아래에 ModelScope 사이트 바로가기를 누르시면 됩니다.)

이 모델은 광범위한 응용 분야를 가지고 있으며 임의의 영어 텍스트 설명을 기반으로 비디오를 추론하고 생성 할 수 있습니다. 일부 생성 비디오 예는 다음과 같으며, 위쪽은 입력 텍스트이고 아래쪽은 해당 생성 비디오입니다.

ModelScope 사용법

모델스코프(ModelScope) 사이트 이용방법

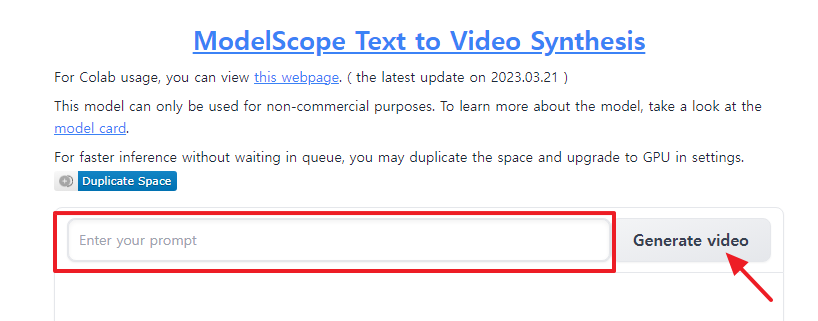

해당 서비스는 현재 데모 버전으로 별도의 가입절차 없이 사용이 가능합니다. 사이트 접속 후 "Enter your prompt"에 프롬프트를 대략 한 문장으로 넣고 오른쪽 "Generate video" 버튼을 누릅니다.

저희 예시로 "A panda eating bamboo on a rock." 번역하면, 돌 위에서 대나무를 먹는 팬다를 입력했을 때 아래와 같이 영상이 나오는 것을 확인 할 수 있습니다.

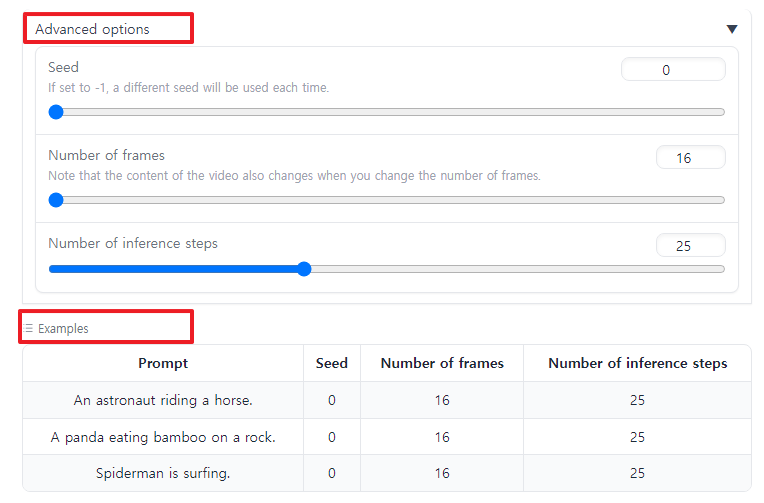

또한 그 아래에 3가지 정도로 다양한 옵션을 통해 영상을 변경할 수 있습니다. Seed는 각각 실행 마다 다른 결과를 보여줄 수 있는 랜덤성이고 그 아래는 영상의 프레임 수, 그리고 inference steps는 25로 보통 맞추어 사용합니다. 직접 해보시면서 숫자를 바꿔보시면 이해가 되실 겁니다.

ModelScope 이용가격

현재 ModelScope 서비스는 현재 데모버젼으로 AI 기술의 집합소인 Hugging Face 플랫폼에서 무료로 시연이 가능합니다. 상단에 사이트 바로가기에서 원하는 텍스트를 넣고 동영상을 마음껏 만들어 보세요.